Strumenti di test per sistemi di intelligenza artificiale

L'onnipresenza mediatica della nuova applicazione di AI ChatGPT di OpenAI dimostra che l'intelligenza artificiale ha raggiunto una maturità impressionante. Il chatbot, che è stato addestrato con dati e testi provenienti da tutta la rete, risponde a domande con risposte difficili, se non impossibili, da distinguere dai testi creati dagli esseri umani. Ma che dire del controllo di qualità dei sistemi di IA?

Il ChatGPT ha scatenato un nuovo clamore sull'intelligenza artificiale, le cui possibilità sono impressionanti. Allo stesso tempo, la garanzia di qualità e il controllo dei sistemi di IA stanno diventando sempre più importanti, soprattutto quando questi assumono compiti di responsabilità. Questo perché i risultati dei chatbot si basano su enormi quantità di dati sui testi provenienti da Internet. Tuttavia, i sistemi come ChatGPT si limitano a calcolare la risposta più probabile a una domanda e a darla come dato di fatto. Ma quali strumenti di test esistono per misurare la qualità dei testi generati da ChatGPT, ad esempio?

Catalogo dei test KI

Strumenti di test in uso

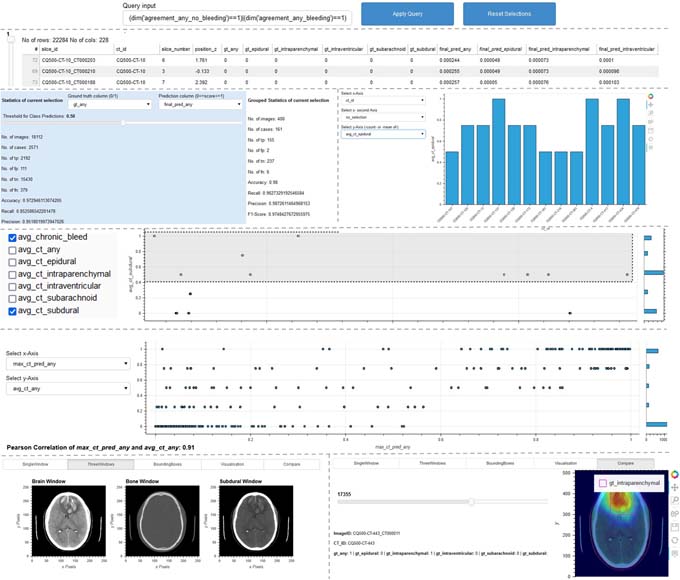

I ricercatori del Fraunhofer IAIS presenteranno inoltre diversi strumenti e procedure di test presso lo stand congiunto del Fraunhofer nel padiglione 16, stand A12 della Hannover Messe 2023 dal 17 al 21 aprile, che possono essere utilizzati per esaminare sistematicamente i sistemi di IA alla ricerca di punti deboli lungo il loro ciclo di vita e per salvaguardarli dai rischi dell'IA. Gli strumenti aiutano gli sviluppatori e gli istituti di controllo a valutare sistematicamente la qualità dei sistemi di IA e a garantirne l'affidabilità. Un esempio è lo strumento "ScrutinAI". Consente agli esaminatori di ricercare sistematicamente i punti deboli delle reti neurali e quindi di testare la qualità delle applicazioni di IA. Un esempio concreto è un'applicazione di IA che rileva anomalie e malattie su immagini TAC. La questione è se tutti i tipi di anomalie vengono rilevati allo stesso modo o se alcuni vengono rilevati meglio e altri peggio. Questa analisi aiuta gli esaminatori a valutare se un'applicazione di IA è adatta al contesto di utilizzo previsto. Allo stesso tempo, anche gli sviluppatori possono trarre vantaggio dalla possibilità di identificare precocemente le carenze dei loro sistemi di IA e adottare misure di miglioramento adeguate, come l'arricchimento dei dati di addestramento con esempi specifici.

Fonte e ulteriori informazioni: Fraunhofer IAIS