Outils de test pour les systèmes d'IA

L'omniprésence médiatique de la nouvelle application d'intelligence artificielle ChatGPT d'OpenAI le montre : l'intelligence artificielle a atteint une maturité impressionnante. Le chatbot, qui a été entraîné avec des données et des textes provenant de tout l'Internet, réagit aux questions avec des réponses qu'il est difficile, voire impossible, de distinguer des textes créés par des humains. Mais qu'en est-il du contrôle de la qualité des systèmes d'IA ?

ChatGPT a déclenché un nouvel engouement pour l'intelligence artificielle, les possibilités de l'IA sont impressionnantes. En même temps, l'assurance qualité et le contrôle des systèmes d'IA deviennent de plus en plus importants - surtout lorsqu'ils assument des tâches à responsabilité. En effet, les résultats du chatbot reposent sur d'énormes quantités de données de textes provenant d'Internet. Des systèmes comme ChatGPT ne calculent toutefois que la réponse la plus probable à une question et la présentent comme un fait. Mais quels outils de contrôle existent pour mesurer par exemple la qualité des textes générés par ChatGPT ?

Catalogue de contrôle de l'IA

Outils de contrôle en action

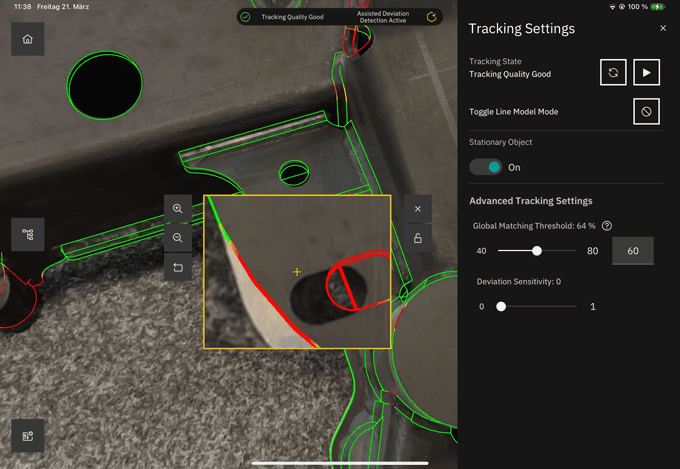

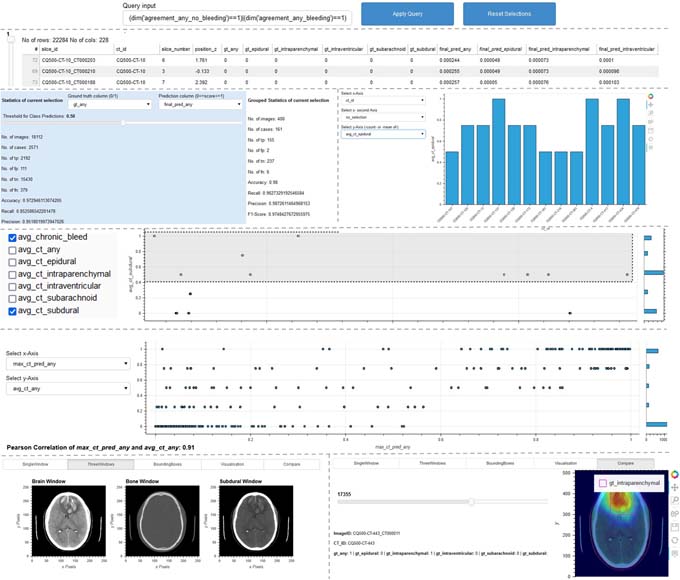

Les chercheurs du Fraunhofer IAIS présenteront en outre, du 17 au 21 avril, à la Foire de Hanovre 2023, sur le stand commun du Fraunhofer (hall 16, stand A12), différents outils et procédures de test permettant d'examiner systématiquement les points faibles des systèmes d'IA tout au long de leur cycle de vie et de les protéger contre les risques liés à l'IA. Ces outils aident les développeurs et les instituts de contrôle à évaluer systématiquement la qualité des systèmes d'IA et à garantir ainsi leur fiabilité. L'outil "ScrutinAI" en est un exemple. Il permet aux contrôleurs de rechercher systématiquement les points faibles des réseaux neuronaux et de tester ainsi la qualité des applications d'IA. Un exemple concret est une application d'IA qui détecte des anomalies et des maladies sur des images de scanner. La question qui se pose ici est de savoir si tous les types d'anomalies sont également bien détectés ou si certains le sont mieux et d'autres moins bien. Cette analyse aide les examinateurs à déterminer si une application d'IA est adaptée au contexte d'utilisation prévu. Parallèlement, les développeurs peuvent également en tirer profit en identifiant à temps les insuffisances de leurs systèmes d'IA et en prenant les mesures d'amélioration qui s'imposent, comme l'enrichissement des données d'entraînement par des exemples spécifiques.

Source et informations complémentaires : Fraunhofer IAIS