Prüftools für KI-Systeme

Die mediale Omnipräsenz der neuen KI-Anwendung ChatGPT von OpenAI zeigt: Künstliche Intelligenz hat eine beeindruckende Reife erreicht. Der Chatbot, der mit Daten und Texten aus dem ganzen Internet trainiert wurde, reagiert auf Fragen mit Antworten, die sich von von Menschen erstellten Texten nur schwer bis gar nicht unterscheiden lassen. Doch wie steht es um die Qualitätsprüfung von KI-Systemen?

ChatGPT hat einen neuen Hype um Künstliche Intelligenz ausgelöst, die Möglichkeiten der KI sind beeindruckend. Gleichzeitig wird die Qualitätssicherung und Kontrolle von KI-Systemen immer wichtiger – insbesondere wenn sie verantwortungsvolle Aufgaben übernehmen. Denn die Ergebnisse des Chatbots beruhen auf riesigen Datenmengen an Texten aus dem Internet. Dabei berechnen Systeme wie ChatGPT allerdings nur die wahrscheinlichste Antwort auf eine Frage und geben diese als Fakt aus. Doch welche Prüftools existieren, um z.B. die Qualität der durch ChatGPT generierten Texte zu messen?

KI-Prüfkatalog

Prüftools im Einsatz

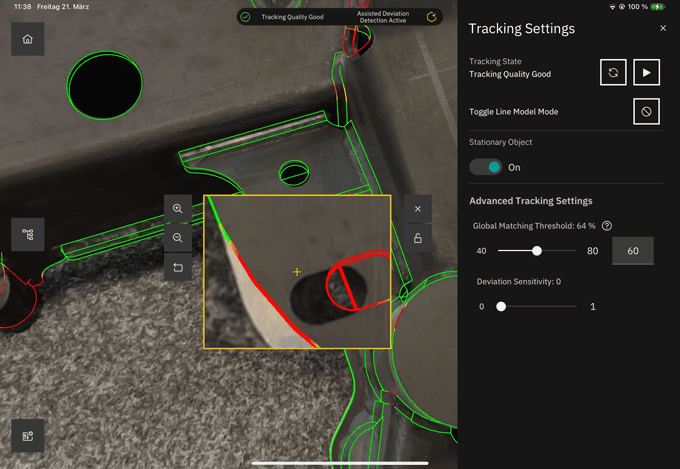

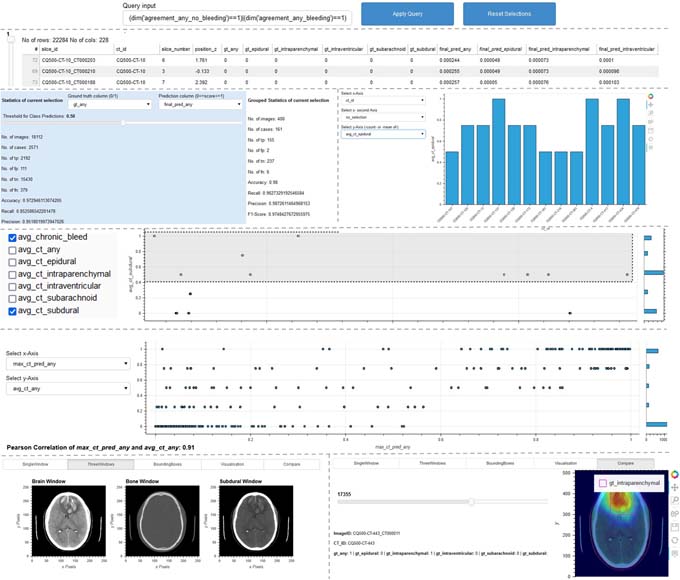

Forschende des Fraunhofer IAIS präsentieren darüber hinaus vom 17. bis 21. April auf der Hannover Messe 2023 am Fraunhofer-Gemeinschaftsstand in Halle 16, Stand A12 verschiedene Prüftools und Verfahren, mit denen sich KI-Systeme systematisch entlang ihres Lebenszyklus auf Schwachstellen untersuchen und gegen KI-Risiken absichern lassen. Die Tools unterstützen Entwickler und Entwicklerinnen sowie Prüfinstitute dabei, die Qualität von KI-Systemen systematisch zu evaluieren und so ihre Vertrauenswürdigkeit sicherzustellen. Ein Beispiel ist etwa das Werkzeug „ScrutinAI“. Es befähigt Prüferinnen und Prüfer, systematisch nach Schwachstellen von neuronalen Netzen zu suchen und somit die Qualität der KI-Anwendungen zu testen. Ein konkretes Beispiel ist eine KI-Anwendung, die Anomalien und Krankheiten auf CT-Bildern erkennt. Hier stellt sich die Frage, ob alle Arten von Anomalien gleichermassen gut erkannt werden oder einige besser und andere schlechter. Diese Analyse hilft Prüferinnen und Prüfern zu beurteilen, ob eine KI-Anwendung für ihren vorgesehenen Einsatzkontext geeignet ist. Gleichzeitig können auch Entwicklerinnen und Entwickler profitieren, indem sie Unzulänglichkeiten ihrer KI-Systeme frühzeitig erkennen und entsprechende Verbesserungsmaßnahmen ergreifen können, wie etwa die Anreicherung der Trainingsdaten um spezifische Beispiele.

Quelle und weitere Informationen: Fraunhofer IAIS