Kommentar: Warum Ingenieure erklärbare KI benötigen

Johanna Pingel, Product Marketing Manager bei MathWorks, einem Entwickler von Software für mathematische Berechnungen, erklärt, welche Methoden KI erklärbar machen und was es braucht, damit das Vertrauen in KI-Modelle wächst.

Entscheidungsträger in Unternehmen aller Branchen setzen zunehmend auf KI, um heute und in Zukunft wettbewerbsfähig zu bleiben. Doch noch immer herrscht Misstrauen gegenüber einer „Black Box“ KI, deren Modelle und Lösungswege für uns Menschen oft nicht mehr nachvollziehbar sind. Dies wird zur Herausforderung, wenn Ingenieure erklären sollen, wie ihre Modelle funktionieren – etwa wenn das Modell bestimmten Regulatorien unterliegt oder wenn potenzielle Käufer davon überzeugt werden sollen.

Was ist Erklärbarkeit von KI?

Hier kommt erklärbare KI ins Spiel. Dabei handelt es sich um eine Reihe von Tools und Methoden, die helfen können, Entscheidungen von KI-Modellen zu verstehen und etwaige Probleme bei Black-Box-Modellen zu entdecken und beheben zu können, wie etwa Voreingenommenheit (Bias) oder eine Anfälligkeit für Manipulationsversuche. Erklärbarkeit ist essenziell, wenn Ingenieure nachweisen müssen, dass ein Modell bestimmten Standards oder ISO-Normen entspricht. Es geht aber auch darum, das Vertrauen in KI-Modelle im Allgemeinen zu steigern.

Erklärbarkeit kann Anwendern von KI helfen zu verstehen, wie Machine Learning Modelle zu Vorhersagen kommen. Dafür können sie zum Beispiel verfolgen, welche Parameter die Entscheidung eines KI-Modells beeinflussen und wie die Einflussnahme aussieht. Doch vor allem bei komplexen Modellen ist dies nicht leicht.

Komplexität vs. Erklärbarkeit

Deshalb stellt sich die Frage: Warum nutzen wir nicht simplere KI-Modelle? Modelle waren nicht immer komplex. Ein einfaches Beispiel dafür ist ein Thermostat, das die Temperatur in einem Raum regelt. Fällt die Temperatur im Raum unter einen gewissen vorgegebenen Wert, schaltet die Heizung sich an, steigt sie über diesen Wert, wird die Heizung wieder abgestellt. Doch was ist mit Parametern wie Tageszeit, Büronutzung, Strompreisen oder der Wettervorhersage? Wie hoch soll die Heizung eingestellt werden, um wirklich effizient und nachhaltig zu arbeiten? Genauso wie eine moderne Temperaturreglung in Gebäuden viel mehr Parameter berücksichtigt, so haben sich in vielen Bereichen Modelle etabliert, die um ein Vielfaches detaillierter und damit komplexer sind.

Diese komplexen Modelle haben den Vorteil, dass sie in der Regel akkuratere Vorhersagen treffen. So können genauere Analysen durchgeführt werden, die in bestimmten Fällen zudem schneller eine Antwort auf gestellte Fragen liefern. Darüber hinaus arbeiten Ingenieure mit immer komplexeren Daten wie etwa gestreamten Signalen und Bildern, die direkt von KI-Modellen verarbeitet werden können. So kann bei der Modellerstellung wertvolle Zeit gespart werden.

Auch wenn die Komplexität all diese positiven Veränderungen mit sich bringt, wird es doch zunehmend zur Herausforderung, dass Modelle nicht mehr verstanden werden. Ingenieure müssen also neue Herangehensweisen entwickeln, um auch komplexe Modelle wieder besser verstehen und Berechnungen nachvollziehen zu können.

Methoden für erklärbare KI

Erklärbare Modelle zu verwenden kann wertvolle Einblicke bieten, ohne dass zusätzliche Schritte zum Workflow hinzugefügt werden müssten. Beispielsweise ist im Falle von Entscheidungsbäumen oder linearen Modellen die Entscheidungsfindung unmittelbar nachvollziehbar, welche Eigenschaften ein Modell wie beeinflussen.

Um den Einfluss bestimmter Merkmale auf die Entscheidung nachvollziehen zu können, gibt es bestimmte Methoden. Durch das „Feature Ranking“ gewinnt man Klarheit, welche Eigenschaften den grössten Einfluss auf eine Entscheidung haben. Anschliessend muss geprüft werden, ob sich der Einfluss eines Merkmals ändert, wenn dieses unterschiedliche Werte annimmt.

Eine andere Methode ist LIME (Local Interpretable Model-Agnostic Explanations). Hier wird versucht, sich in der Umgebung eines bestimmten Datenpunkts einem komplexen, nicht erklärbaren System durch das Erstellen eines weniger komplexen, erklärbaren Geschwister-Modells anzunähern, das ähnliche Ergebnisse erzielt. So kann herausgefunden werden, welche Prädiktoren die Entscheidung am meisten beeinflussen.

Wie aber entdeckt man nichtlineare Abhängigkeiten unter den Eingangsdaten? Dafür können Ingenieure „Shapley Values“ nutzen. Mit ihnen lässt sich abschätzen, wie die Eingangsdaten eines Machine Learning-Modells die Ergebnisse beeinflussen.

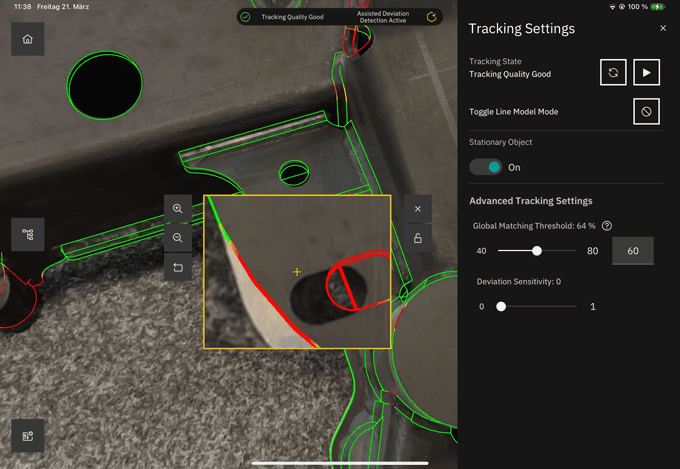

Bei der Erstellung von Modellen für Bildverarbeitungs- oder Computer-Vision-Anwendungen gehören Visualisierungen zu den besten Möglichkeiten, um die Erklärbarkeit von Modellen zu beurteilen. Zum Beispiel können Methoden wie Grad-CAM und “occlusion sensitivity” diejenigen Stellen in Bildern und Texten identifizieren, die die Entscheidung des Modells am stärksten beeinflussen.

KI jenseits von Erklärbarkeit

Um erklärbare KI erfolgreich zu nutzen, müssen sich Ingenieure und Wissenschaftler auch der Herausforderungen bewusst sein, die damit einhergehen. Eine Balance zwischen Erklärbarkeit, Komplexität, Einfluss von Eingangsdaten und Vertrauen in Modelle zu finden ist nicht leicht. Zudem muss klar sein, dass die Erklärung einer Black Box und das damit gewonnene Vertrauen bei Entscheidern oder Kontrollinstanzen nur ein Schritt auf der Reise zum sicheren Einsatz von KI ist.

Der Einsatz von KI in der Praxis erfordert Modelle, die verstanden werden können. Sie müssen nach einem nachvollziehbaren Verfahren erstellt worden sein und auf einem Niveau arbeiten können, das für sicherheitskritische und sensible Anwendungen notwendig ist. An dieser Stelle setzen Experten auf Verifizierung und Validierung. So können sie sicherstellen, dass ein Modell, das in sicherheitskritischen Anwendungen eingesetzt wird, Mindeststandards erfüllt. Oder sie definieren Sicherheitszertifizierungen für Bereiche wie die Automobilbranche oder Luftfahrt. Ingenieure haben viele Tools und Möglichkeiten zur Hand, um das Vertrauen in KI zu steigern. Sie sollten nicht bei Erklärbarkeit aufhören.

Fazit: Erklärbare KI als Rädchen in einem Gesamtsystem

Ohne Frage wird KI in Zukunft einen starken Fokus auf Erklärbarkeit haben. Je mehr KI in sicherheitskritische und alltägliche Anwendungen integriert wird, umso mehr wird Erklärbarkeit als unerlässliches Attribut von KI-Modellen betrachtet werden. Und davon profitieren alle: Ingenieure haben bessere Informationen über ihre Modelle und können Fehler schneller finden und beheben. Sie können nachvollziehbar erklären, wie die Modelle bestimmte Standards erfüllen, und diese grössere Transparenz gibt sowohl Entscheidungsträgern als auch potenziellen Kunden Vertrauen.

Dennoch sollten Ingenieure, Fachexperten und Entscheidungsträger in Unternehmen nicht vergessen, dass Erklärbarkeit nur ein Zahnrad in einem grossen Uhrwerk ist und Hand in Hand – Zahn in Zahn – mit anderen wichtigen Methoden, Tools und Regelungen eingesetzt werden muss.

Quelle und weitere Informationen: https://ch.mathworks.com/de/